GLM-4.5V是什么

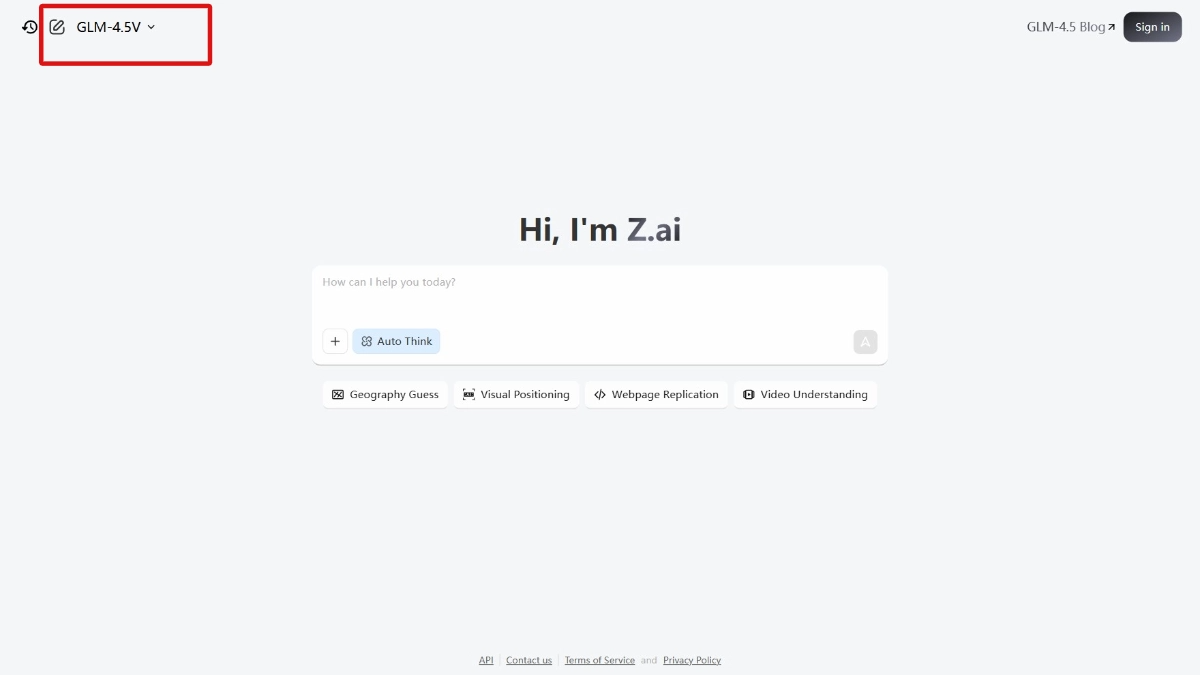

GLM-4.5V是智谱推出的视觉推理模型。模型基于106B参数规模构建,拥有12B激活能力,是目前领先的视觉语言模型(VLM)。模型在视觉理解、推理以及多模态交互方面表现出色,能处理图像、视频等视觉内容,支持与文本进行融合处理。GLM-4.5V支持网页前端复刻、图寻游戏、视频理解等多种应用场景,为开发者提供了强大的工具。智谱开源了桌面助手应用,方便用户实时体验其功能。GLM-4.5V的开源和应用有望推动多模态技术的进一步发展。

GLM-4.5V的主要功能

- 视觉理解与推理:能精准分析图像、视频等视觉内容,识别物体、场景和人物关系,完成复杂的视觉推理任务。

- 多模态交互:支持文本与视觉内容的融合处理,根据文本生成图像,或根据图像生成文本描述,实现多模态内容的无缝转换。

- 网页前端复刻:通过上传网页设计图,快速生成前端代码,助力开发者高效实现网页开发。

- 图寻游戏:在复杂场景中快速找到目标图像,适用安防监控、智能零售及娱乐游戏开发。

- 视频理解:分析视频内容,提取关键信息,生成视频摘要或检测事件,优化视频推荐、编辑及监控。

- 跨模态生成:从视觉内容生成文本,或者从文本生成视觉内容,满足多种多模态应用需求。

GLM-4.5V的官网地址

- GitHub仓库:https://github.com/zai-org/GLM-V/

- HuggingFace模型库:https://huggingface.co/collections/zai-org/glm-45v-68999032ddf8ecf7dcdbc102

- 技术论文:https://github.com/zai-org/GLM-V/tree/main/resources/GLM-4.5V_technical_report.pdf

- 桌面助手应用:https://huggingface.co/spaces/zai-org/GLM-4.5V-Demo-App

GLM-4.5V的相关的人工智能知识

- 视觉语言模型(VLM):视觉语言模型是将视觉信息(如图像、视频)与语言信息(如文本)相结合的人工智能模型。通过学习视觉内容与文本之间的关联,理解图像或视频中的场景、物体及其关系,生成相应的文本描述,或根据文本描述生成图像。GLM-4.5V作为先进的视觉语言模型,通过大规模预训练和多模态任务微调,实现视觉与语言的深度融合。

- 多模态交互:多模态交互是指人工智能系统能同时处理多种模态的信息(如文本、图像、语音等),实现它们之间的交互与转换。GLM-4.5V支持文本与视觉内容的融合处理,根据文本描述生成图像,或者根据图像生成文本描述,能在视觉内容中执行基于文本指令的任务,例如在图像中找到符合描述的物体,使得模型在多种应用场景中具有广泛的应用潜力。

- 大规模预训练:大规模预训练是现代人工智能模型训练的一种重要方法。通过在海量的数据上进行无监督或自监督学习,模型能学习到语言、视觉等模态的基本特征和规律,具备通用的表示能力和知识基础。GLM-4.5V基于106B参数的预训练架构,用大量的文本和视觉数据进行训练,学习语言和视觉的联合表示,为其在各种多模态任务中的出色表现奠定基础。

- 激活机制:激活机制是指在模型推理过程中,根据任务需求动态激活相关的参数子集。GLM-4.5V设计12B激活参数,在推理时仅激活与当前任务相关的部分参数,提高计算效率,降低资源消耗,提升模型的推理性能,使其能在复杂的多模态任务中快速准确地做出响应。

相关文章

暂无评论...