Klear-Reasoner是什么

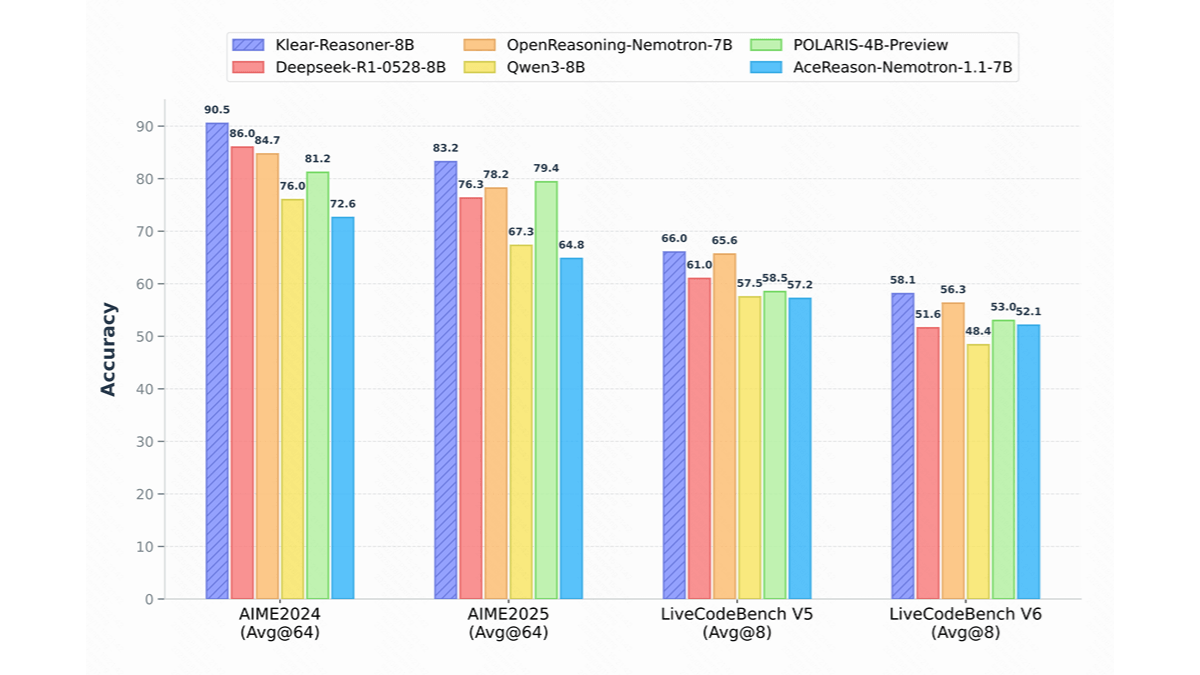

Klear-Reasoner 是快手开源的推理模型,基于 Qwen3-8B-Base 构建,专注于提升数学和代码推理能力。模型通过长思维链监督微调和强化学习训练,创新性地采用 GPPO 算法,解决传统方法中探索能力受限和负样本收敛慢的问题。Klear-Reasoner 在 AIME 和 LiveCodeBench 等基准测试中表现优异,达到 8B 模型的顶尖水平。Klear-Reasoner 能处理复杂的数学问题和代码生成任务,适用教育、软件开发、金融科技等多个领域,为推理模型的发展提供重要的参考和复现路径。

Klear-Reasoner的主要功能

- 数学推理:能解决高难度数学竞赛题目,提供详细解题步骤。

- 代码生成与推理:支持生成高质量代码片段,在 LiveCodeBench 测试中表现优异。

- 长思维链推理:基于长思维链监督微调和强化学习,提升多步推理能力。

- 数据质量优化:能优先选择高质量数据源,保留部分错误样本增强探索能力。

Klear-Reasoner的官网地址

- GitHub仓库:https://github.com/suu990901/KlearReasoner/

- HuggingFace模型库:https://huggingface.co/Suu/Klear-Reasoner-8B

- arXiv技术论文:https://arxiv.org/pdf/2508.07629

Klear-Reasoner相关的人工智能知识

- 长思维链监督微调(long CoT SFT):长思维链监督微调是针对复杂推理任务的训练方法。通过使用高质量的数据源对模型进行监督学习,确保模型能学习到准确的推理模式。能优先选择少数高质量的数据源,避免低质量数据引入噪声,同时保留部分错误样本增强模型的探索能力,在高难度任务中效果显著。

- 强化学习(RL):强化学习是通过奖励机制训练模型的方法。在 Klear-Reasoner 中,强化学习用在进一步提升模型的推理能力,特别是在数学和代码任务上。模型基于软奖励机制,根据测试用例的通过率给予奖励,缓解奖励稀疏问题,增加训练信号的密度,让模型的学习过程更稳定、更高效。

- GPPO(Gradient-Preserving Clipping Policy Optimization)算法:GPPO 是改进的策略优化算法。传统 PPO 和 GRPO 算法中,clip 操作会丢弃高熵 token 的梯度,限制模型的探索能力。GPPO 基于 stop gradient 操作,将 clip 操作与梯度反向传播解耦,保留所有 token 的梯度,特别是对高熵 token 和负样本 token,GPPO 保留其梯度并进行适当约束,加快错误修正速度。

- 软奖励机制:软奖励机制是改进的奖励策略,用在强化学习中的代码任务。与硬奖励(完全通过得分,否则为零)相比,软奖励机制根据测试用例的通过率给予奖励,缓解奖励稀疏问题,增加训练信号的密度,降低梯度估计的方差,让模型的学习过程更稳定、更高效。

相关文章

暂无评论...