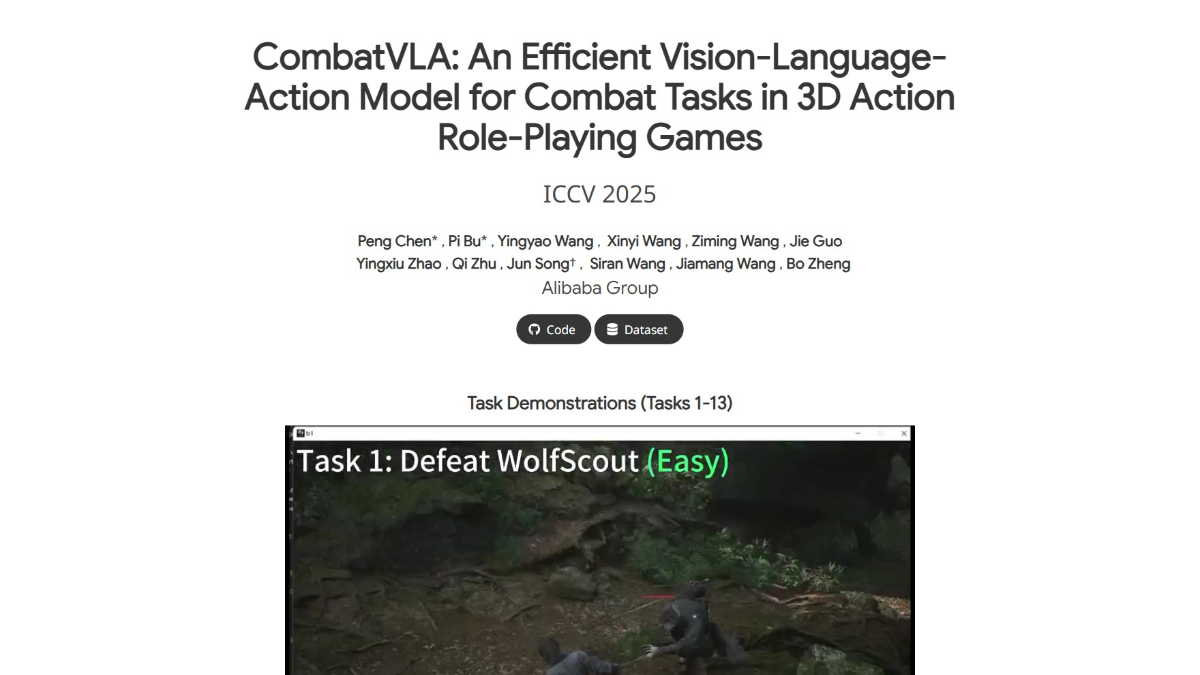

CombatVLA是什么

CombatVLA是淘天集团未来生活实验室团队推出的专为3D动作角色扮演游戏(ARPG)设计的视觉-语言-动作(VLA)模型。模型用3B参数规模,通过动作追踪器收集数据并转化为“动作思维”序列进行训练,基于三阶段渐进式学习范式,实现高效推理。模型能在复杂3D游戏环境中实时做出战斗决策,包括躲避攻击、发动技能等,决策速度比传统模型快50倍,且在战斗理解基准测试中表现优异,任务成功率高于人类玩家,具有很强的泛化能力。

CombatVLA的主要功能

- 实时战斗决策:CombatVLA 能在复杂的3D游戏环境中迅速做出战斗决策,例如躲避敌人的攻击、发动技能、恢复生命值等,决策速度比传统模型快50倍。

- 战斗理解与推理:模型能精准评估敌人的状态和攻击意图,推理出最优的战斗动作,战斗理解能力显著优于其他模型。

- 动作指令生成:CombatVLA 能输出具体可执行的键鼠操作指令,直接控制游戏角色进行战斗,实现高效的动作执行。

- 泛化能力:在不同难度的任务中和全新的游戏场景里,CombatVLA 均能展现出强大的泛化能力,有效执行战斗任务。

CombatVLA的官网地址

- 项目官网:https://combatvla.github.io/

- GitHub仓库:https://github.com/ChenVoid/CombatVLA

- arXiv技术论文:https://arxiv.org/pdf/2503.09527

CombatVLA相关的人工智能知识

- 视觉-语言-动作(VLA)模型:视觉-语言-动作(VLA)模型是多模态人工智能模型,结合视觉信息(如游戏画面)、语言信息(如动作描述)和动作指令(如键鼠操作)。模型通过理解视觉场景、解析语言指令,能生成相应的动作输出,实现在复杂环境中的高效交互。

- 动作追踪器:动作追踪器是收集人类玩家游戏操作数据的重要工具。基于同步记录键盘和鼠标操作及游戏画面,生成视频动作对数据。数据经过处理后,能用在训练人工智能模型,使其能学习和模仿人类玩家的操作习惯和策略。

- 动作思维(AoT)序列:动作思维(Action-of-Thought,AoT)序列是将动作数据转化为语义化和逻辑化的格式。每个动作包含操作指令,且附带详细的解释,帮助模型理解动作的背景和目的。

- 三阶段渐进式学习:三阶段渐进式学习是分层次的训练方法,能逐步提升模型的性能。第一阶段是视频级微调,让模型初步理解战斗环境;第二阶段是帧级微调,帮助模型理解动作与前序帧的严格对齐;第三阶段是帧级截断微调,通过引入特殊标记 <TRUNC>,截断输出加速推理。

- 自适应动作权重损失:自适应动作权重损失是优化训练过程的技术。基于动作对齐损失和模态对比损失,确保模型准确输出关键动作。动作对齐损失帮助模型学习动作与环境的对齐关系,模态对比损失确保模型在不同模态(如视觉和语言)之间保持一致性。

相关文章

暂无评论...