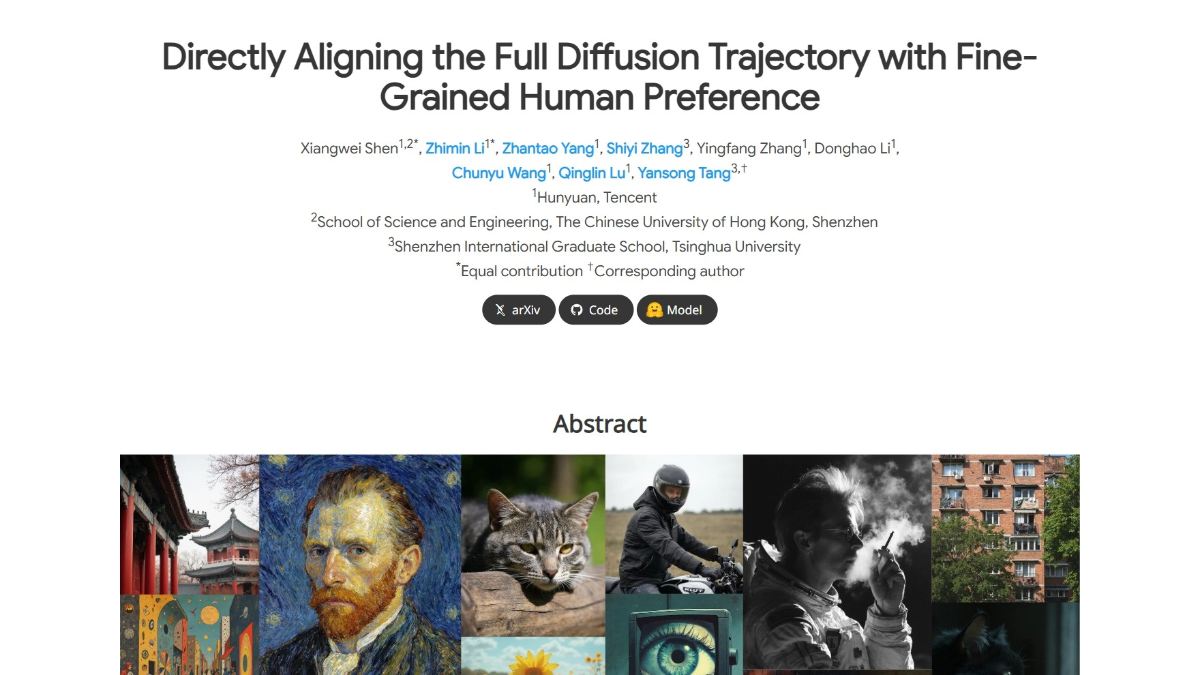

SRPO是什么

SRPO是腾讯混元推出的先进的文本到图像生成模型,模型用语义相对偏好优化技术,将奖励信号与文本条件相结合,支持动态调整奖励信号,能更好地适应不同任务需求和人类偏好。SRPO用Direct-Align技术,在训练过程中直接从任意时间步恢复原始图像,有效避免后期时间步的过度优化问题,显著提升图像生成的质量和训练效率。SRPO在数字艺术创作、广告与营销、游戏开发、影视制作及虚拟现实和增强现实等多个领域具有广泛的应用前景,为用户提供高效、灵活且高质量的图像生成体验。

SRPO的主要功能

-

提升生成效果:SRPO能生成高质量的图像,显著增强图像的真实感、细节表现力和整体美感,满足不同场景下的高要求。

-

灵活调整偏好:借助文本提示,用户能实时动态地调整图像生成的风格和偏好,无需复杂的离线奖励模型微调,操作便捷高效。

-

优化适应能力:模型具备出色的适应性,支持根据不同任务需求灵活调整生成策略。

-

高效训练过程:通过优化扩散过程,SRPO大幅提升训练效率,在极短的时间内完成优化,显著节省时间和计算资源。

SRPO的官网地址

- 项目官网:https://tencent.github.io/srpo-project-page/

- GitHub仓库:https://github.com/Tencent-Hunyuan/SRPO

- HuggingFace模型库:https://huggingface.co/tencent/SRPO

- arXiv技术论文:https://arxiv.org/pdf/2509.06942v2

SRPO相关的人工智能知识

- 扩散模型(Diffusion Models):扩散模型是生成模型,通过逐步去除噪声生成数据。模型从高斯噪声开始,逐步恢复出目标数据,类似于物理中的扩散过程。SRPO用扩散模型的这一特性,通过优化扩散过程中的奖励信号,生成更符合人类偏好的图像。

- 在线强化学习(Online Reinforcement Learning):在线强化学习是一种机器学习方法,智能体通过与环境的交互学习最优行为策略。SRPO通过在线强化学习动态调整奖励信号,使模型能实时响应用户偏好,生成更高质量的图像。

- 文本条件信号(Text-Conditioned Signals):文本条件信号是指模型根据文本提示生成或调整输出。SRPO将奖励信号设计为文本条件信号,支持用户通过简单的文本提示动态调整图像生成的风格和偏好,提高模型的灵活性和适应性。

- 相对偏好机制(Relative Preference Mechanism):相对偏好机制通过比较正负提示词对的奖励差异优化模型。SRPO用这一机制增强目标属性的优化,通过负奖励信号抑制不希望的属性,提高生成图像的质量。

相关文章

暂无评论...