InternVL3.5是什么

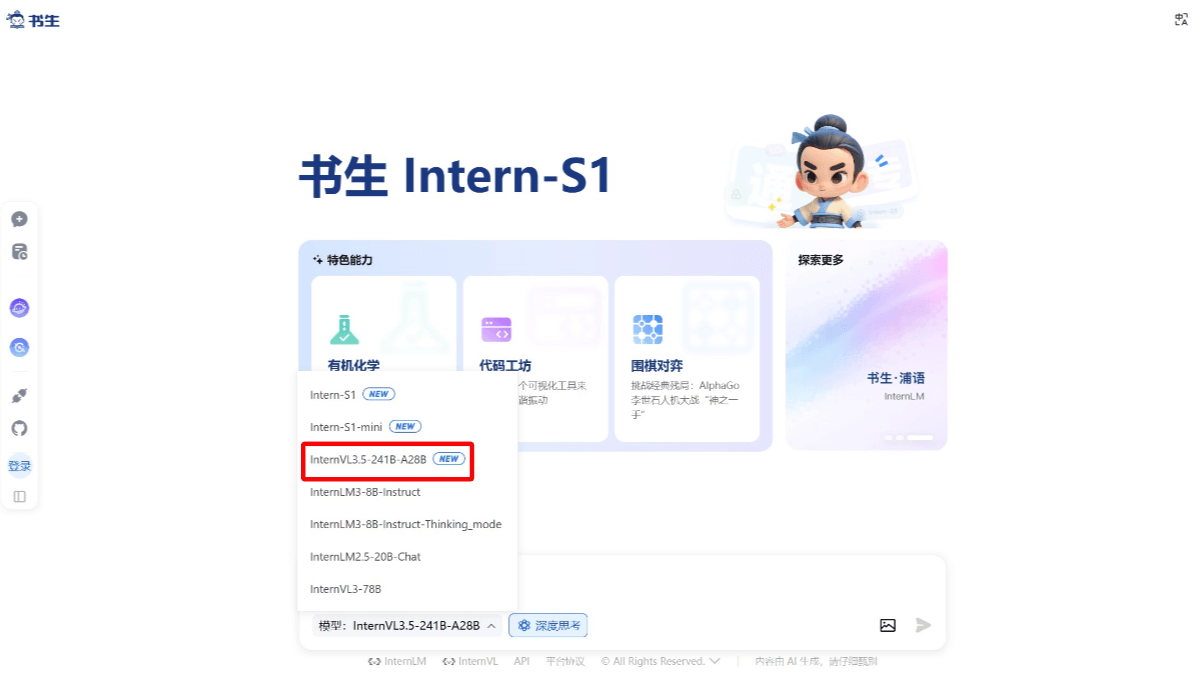

InternVL3.5(书生·万象3.5)是上海AI Lab开源的多模态大模型。模型在通用能力、推理能力和部署效率上全面升级,提供从10亿到2410亿参数的九种尺寸版本,覆盖不同资源需求场景,包含稠密模型和专家混合模型(MoE),是首个支持GPT-OSS语言模型基座的开源多模态大模型。强化了 GUI 智能体、具身空间推理和矢量图形处理等智能体核心能力。InternVL3.5 采用级联式强化学习(Cascade RL)框架,通过“离线预热-在线精调”两阶段流程,显著提升推理能力。旗舰模型 InternVL3.5-241B-A28B 在多学科推理基准 MMMU 中获得开源模型最高分77.7分,超越 GPT-5。借助动态视觉分辨率路由(ViR)和解耦部署框架(DvD),模型在高分辨率输入下的响应速度大幅提升,38B 模型的吞吐量提升达4.05倍。

InternVL3.5的主要功能

-

多模态感知:在图像、视频问答等多模态感知任务中表现出色,241B-A28B 模型以 74.1 的平均得分超越现有开源模型,接近商业模型 GPT-5(74.0)。

-

多模态推理:在多学科推理基准 MMMU 中获得 77.7 分,较前代提升超 5 个百分点,位列开源榜首。

-

文本能力:在 AIME、GPQA 及 IFEval 等多个基准中,模型可以取得 85.3 的均分,处于开源领先。

-

GUI 智能体:强化了 GUI 智能体能力,可实现跨平台自动化操作,例如在 ScreenSpot GUI 定位任务中以 92.9 分超越主流开源模型。

-

具身空间推理:具备更强的 grounding 能力,可以泛化到全新的复杂具身场景,支持可泛化的长程物体抓取操作。

-

矢量图形处理:在 SGP-Bench 以 70.7 分刷新开源纪录,能够有效应用于网页图形生成与工程图纸解析等专业场景。

InternVL3.5的官网地址

- Github仓库:https://github.com/OpenGVLab/InternVL

- HuggingFace模型地址:https://huggingface.co/OpenGVLab/InternVL3_5-241B-A28B

- 技术报告:https://huggingface.co/papers/2508.18265

- 在线体验地址:https://chat.intern-ai.org.cn/

InternVL3.5相关的人工智能知识

-

多模态学习:多模态学习是人工智能的一个重要分支,模拟人类处理信息的方式,将视觉、语言、听觉等多种模态的数据结合起来进行学习。书生·万象 InternVL3.5 能同时处理图像和文本,通过这种方式,模型可以更全面地理解世界,就像人类在看图说话时,会结合图片内容和语言知识来表达一样。这种学习方式可以提高模型在复杂任务中的表现,比如图像描述生成、视觉问答等。

-

强化学习:强化学习是一种让机器通过与环境的交互来学习最优行为策略的方法。在书生·万象 InternVL3.5 中,采用了级联式强化学习框架,先通过离线强化学习快速提升基础能力,再通过在线强化学习进一步优化性能。这就好比一个人先通过模拟考试熟悉题型,然后再参加真实考试来提高成绩,让模型在复杂任务中表现得更加智能和高效。

-

视觉编码器:视觉编码器是多模态模型中处理视觉信息的关键组件,能将图像或视频等视觉数据转换成模型可以理解和处理的特征表示。书生·万象 InternVL3.5 使用高效的视觉编码器,能准确地提取视觉信息中的关键特征,就像人类的大脑能够快速识别出图片中的物体一样,为后续的多模态融合和任务处理提供了坚实的基础。

-

语言模型:语言模型是处理和生成自然语言文本的工具,能理解人类的语言并生成符合语法规则和语义逻辑的文本。书生·万象 InternVL3.5 结合了强大的语言模型,支持多种文本相关的任务,如问答、文本生成等。使模型能像人类一样进行语言交流和创作,为各种自然语言处理应用提供了强大的支持。

-

模型部署:模型部署是将训练好的人工智能模型应用到实际场景中的过程。书生·万象 InternVL3.5 采用了解耦部署架构,将视觉编码器和语言模型分别部署在不同的 GPU 上,提高了模型的推理速度和资源利用效率。这就像是在一个工厂中,将不同的生产线分开,让它们可以并行工作,从而提高整个工厂的生产效率。

-

智能体技术:智能体技术是指让模型具备自主与环境交互并完成特定任务的能力。书生·万象 InternVL3.5 的 GUI 智能体可以自动化操作软件界面,具身智能体可以进行物理空间的导航和交互。就好比给模型赋予了“手脚”,能像人类一样在虚拟或现实环境中自主地完成任务,如操作电脑软件、控制机器人移动等。

相关文章

暂无评论...