MobileCLIP2是什么

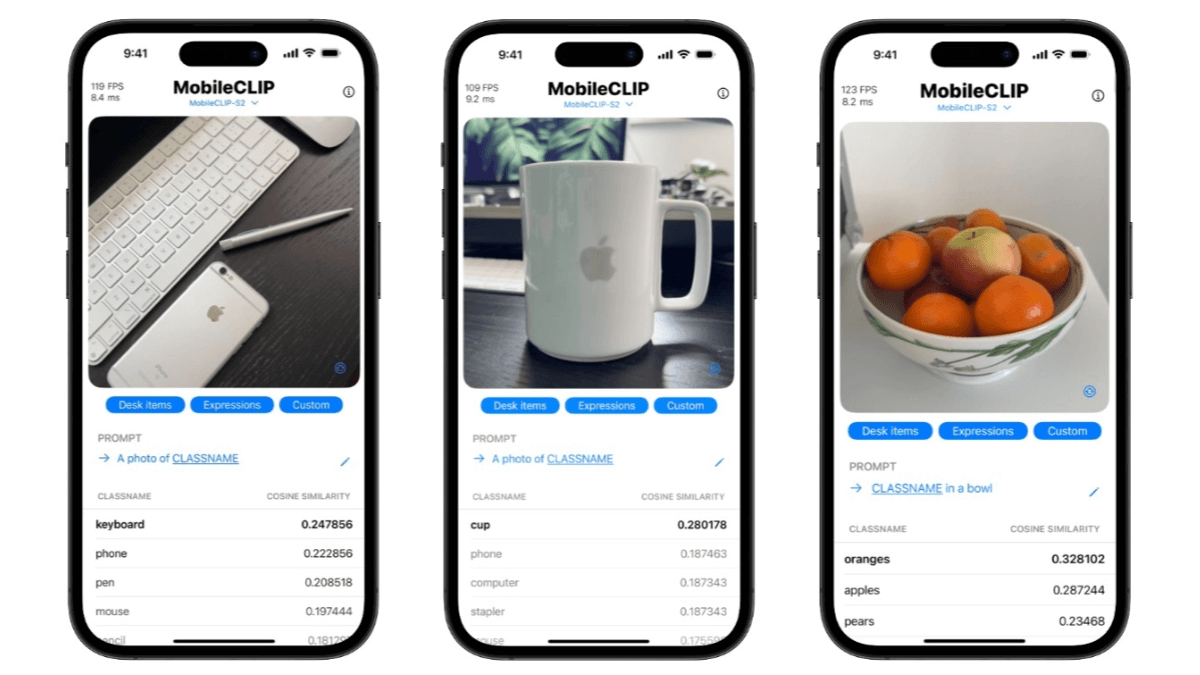

MobileCLIP2是苹果公司推出的开源高效端侧多模态模型,在多模态强化训练方面进行了优化,通过在DFN数据集上训练性能更优的CLIP教师模型集成和改进的图文生成器教师模型,进一步提升了模型性能。MobileCLIP2在零样本分类任务上表现出色,例如在ImageNet-1k零样本分类任务中,准确率较MobileCLIP-B提升了2.2%。MobileCLIP2-S4在保持与SigLIP-SO400M/14相当的性能的同时,模型规模更小,推理延迟更低。在多种下游任务中也展现了良好的性能,包括视觉语言模型评估和密集预测任务等。MobileCLIP2适用于图像检索、内容审核和智能相册等多种应用场景,能基于文本描述检索相关图像、进行图文一致性检查以及自动图像分类等。

MobileCLIP2的主要功能

-

零样本图像分类:基于预训练的多模态特征,直接对图像进行分类,无需额外训练数据,可快速适应新任务。

-

文本到图像检索:根据输入的文本描述,从图像库中检索出与之最相关的图像,实现精准的图像搜索。

-

图像到文本生成:基于输入图像生成描述性的文本,为图像添加合适的标题或描述,辅助内容理解和创作。

-

图文一致性判断:评估图像与文本描述之间的匹配度,可用于内容审核、智能相册分类等场景,确保图文相符。

-

多模态特征提取:为图像和文本提取高质量的多模态特征,支持下游任务如图像分类、目标检测、语义分割等,提升模型性能。

MobileCLIP2的官网地址

- Github仓库:https://github.com/apple/ml-mobileclip

- HuggingFace模型库:https://huggingface.co/collections/apple/mobileclip2-68ac947dcb035c54bcd20c47

MobileCLIP2相关的人工智能知识

-

多模态学习:多模态学习是一种人工智能技术,通过整合多种模态的数据(如图像、文本、音频等)来提升模型对复杂信息的理解能力。模拟人类处理信息的方式,模型能更全面地感知世界。例如,MobileCLIP2通过学习图像和文本之间的关系,能更好地理解图像内容并生成相关的文本描述。

-

零样本学习:零样本学习是一种机器学习方法,模型能在没有直接样本的情况下识别新类别。通过学习已知类别的特征和语义信息,推断未知类别的属性。MobileCLIP2利用零样本学习技术,可以根据文本描述对未见过的图像类别进行分类,大大扩展了模型的应用范围。

-

知识蒸馏:知识蒸馏是一种模型压缩技术,通过将大型复杂模型(教师模型)的知识传递给小型模型(学生模型),使学生模型在保持高效的同时获得更好的性能。MobileCLIP2通过知识蒸馏技术,从大型教师模型中提取关键信息,优化了模型的结构和性能,使其更适合在资源受限的设备上运行。

-

对比学习:对比学习是一种自监督学习方法,通过学习数据样本之间的相似性和差异性来训练模型。通过构造正样本对和负样本对,让模型学习区分相似和不相似的数据。MobileCLIP2利用对比学习来训练图像和文本的联合表示,使模型能更准确地匹配图像和文本。

-

端侧计算:端侧计算是指在本地设备(如智能手机、物联网设备等)上进行数据处理和分析,而不是将数据发送到云端。这种方式可以减少延迟、节省带宽,并提高数据的隐私性。MobileCLIP2通过优化模型结构,能在端侧设备上高效运行,为用户提供快速响应和隐私保护。

-

强化学习:强化学习是一种机器学习方法,通过让智能体在环境中采取行动并根据奖励信号学习最优策略。虽然MobileCLIP2的主要技术不是强化学习,但在训练过程中可能涉及强化学习机制,例如通过奖励信号来优化模型的性能,使其在特定任务中表现更好。

-

特征提取:特征提取是深度学习中的一个关键步骤,通过从原始数据中提取有用的信息来提高模型的性能。MobileCLIP2能从图像和文本中提取高质量的特征,这些特征可以用于多种下游任务,如图像分类、目标检测和语义分割,为模型的多模态融合提供了坚实的基础。

相关文章

暂无评论...