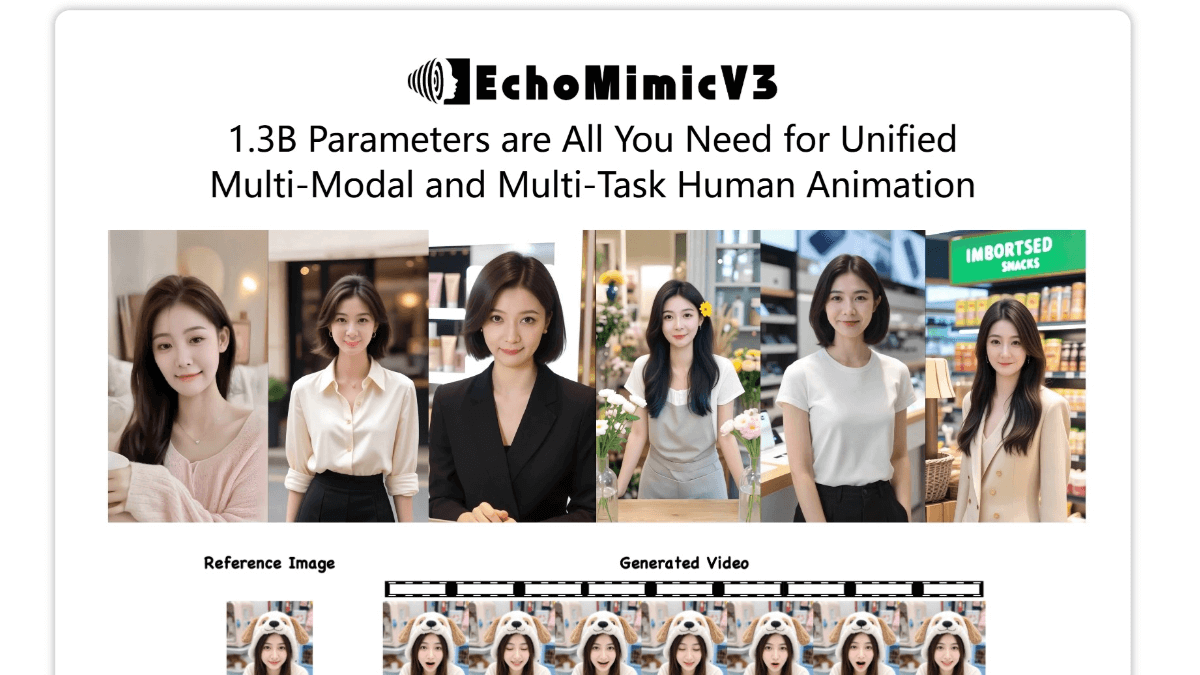

EchoMimicV3是什么

EchoMimicV3 是蚂蚁集团支付宝终端技术部推出的多模态人类动画生成系统。基于紧凑型视频扩散模型(CVDM),通过创新的“任务融合”和“模态融合”设计,能根据音频、图像或文本输入,生成自然流畅的人类动作和口型动画。采用三层注意力机制,精准捕获视觉与音频的交互以及帧间依赖关系,支持多种动画任务,如语音驱动的口型生成、文本驱动的动作生成等。参数量仅为1.3B,训练与推理效率高,通过“从难到易”的训练策略和多模态时间步相位感知动态分配机制,显著提升了动画生成的细节表现和自然度。

EchoMimicV3的主要功能

-

多模态输入支持:能接收音频、图像和文本等多种模态的输入,为动画生成提供丰富的信息来源。

-

动作与口型生成:根据输入生成自然流畅的人类动作和口型动画,使虚拟角色的表达更加生动逼真。

-

跨任务能力:统一处理多种动画任务,如语音驱动的口型生成、文本驱动的动作生成等,适应不同应用场景。

-

高效模型架构:采用紧凑型视频扩散模型,仅1.3B参数量,兼顾性能与效率,便于实际应用部署。

-

细节捕捉与优化:通过时间步感知函数等技术,精准捕捉动画细节,提升生成动画的质量和自然度。

EchoMimicV3的技术优势

-

紧凑高效的模型架构:采用紧凑型视频扩散模型(CVDM),仅1.3B参数量,在保持高效性能的同时,降低了计算资源需求,便于快速部署和广泛应用。

-

多模态融合处理能力:通过“耦合-解耦-混合”工作流,支持音频、图像和文本等多种模态输入,增强模型对不同信息的处理能力,实现更丰富的动画生成效果。

-

创新的注意力机制:三层注意力机制(参考注意力层、音频注意力层、时间注意力层)精准捕获视觉与音频的交互及帧间依赖关系,提升动画生成的自然度和连贯性。

-

任务融合训练策略:将多种动画任务统一为时空重建问题,采用“从难到易”的训练策略,实现跨任务知识迁移,提升模型的泛化能力和适应性。

-

动态模态权重分配:引入多模态时间步相位感知动态分配(Multi-Modal PhDA)机制,根据时间步阶段动态调整模态权重,优化多模态信息融合效果。

-

高效的训练与推理:采用Negative DPO-SFT循环训练,结合MSE和LPIPS损失,并引入时间步感知函数减少大时间步的权重,提升细节捕捉能力,同时优化推理效率。

EchoMimicV3的官网地址

- 项目官网:https://antgroup.github.io/ai/echomimic_v3/

- GitHub仓库:https://github.com/antgroup/echomimic_v3

- HuggingFace模型库:https://huggingface.co/BadToBest/EchoMimicV3

- arXiv技术论文:https://arxiv.org/pdf/2507.03905

EchoMimicV3的应用场景

-

虚拟数字人:为虚拟主播、AI 客服、智能助手等生成自然的动作和口型,提升交互体验。

-

影视与游戏制作:快速生成动画片段,降低动作捕捉成本和时间,修复影视中口型与台词不匹配的问题。

-

教育与研究:辅助语言学习,生成带口型的外语教学动画;用于心理学、人类行为研究,分析语调对表情的影响。

-

无障碍技术:帮助语言障碍者通过文本或图像生成表达动作,为听障人士提供可视化语音内容。

EchoMimicV3相关的人工智能知识

-

多模态学习:多模态学习是指让人工智能模型同时处理多种类型的数据,比如图像、文本、音频等。这种方式可以模拟人类处理信息的方式,因为人类也是通过多种感官来感知世界的。通过多模态学习,模型可以更全面地理解信息,提高其在各种任务中的表现,例如在生成动画时,结合音频和文本可以生成更自然的动作和口型。

-

视频扩散模型(Video Diffusion Model):视频扩散模型是一种先进的生成模型,通过逐步去除噪声来生成视频内容。这种模型的核心思想是从一个完全随机的噪声开始,然后通过一系列的去噪步骤,逐渐生成清晰的视频帧。EchoMimicV3 使用的紧凑型视频扩散模型(CVDM)在保持高效的同时,能生成高质量的动画,适用于多种应用场景。

-

注意力机制(Attention Mechanism):注意力机制是一种模拟人类注意力的人工智能技术,可以让模型在处理数据时,自动聚焦于更重要的部分。在EchoMimicV3中,多层注意力机制分别处理视觉、音频和时间信息,使模型能更好地理解和生成自然流畅的动画。提高了模型对细节的捕捉能力,提升了动画的质量和连贯性。

-

任务融合(Soup-of-Tasks):任务融合是一种将多种相关任务统一处理的方法,通过共享模型参数和训练策略,实现跨任务的知识迁移。这种方法可以让模型在多个任务之间共享信息,提高其泛化能力和效率。在EchoMimicV3中,任务融合使模型能同时处理多种动画生成任务,如语音驱动的口型生成和文本驱动的动作生成。

-

模态融合(Soup-of-Modals):模态融合是指将不同模态的数据(如音频、图像、文本)进行整合处理,以增强模型对复杂输入的适应性。EchoMimicV3通过动态分配权重来优化多模态信息的处理,使模型能更好地理解和生成与输入模态相匹配的动画。这种方法提高了模型在多模态任务中的表现,能生成更自然和逼真的动画。

-

深度学习(Deep Learning):深度学习是人工智能的一个重要分支,利用多层神经网络进行学习和预测。通过大量的数据训练,深度学习模型可以自动学习数据中的复杂模式和特征。EchoMimicV3就是基于深度学习模型构建的,通过学习大量的动作和口型数据,能生成高质量的动画,广泛应用于虚拟数字人、影视制作等领域。

-

强化学习(Reinforcement Learning):强化学习是一种通过奖励机制来优化模型行为的学习方法。模型在环境中采取行动,根据环境的反馈获得奖励或惩罚,学习最优的行为策略。虽然EchoMimicV3主要基于扩散模型,但在训练过程中可能会用到强化学习来优化生成动画的质量,使更符合人类的审美和行为习惯。

-

自然语言处理(Natural Language Processing, NLP):自然语言处理是人工智能中用于处理和理解人类语言的技术。可以让模型理解和生成文本信息,实现与人类的自然交互。在EchoMimicV3中,自然语言处理技术使模型能根据文本输入生成相应的动作或口型动画,例如根据一段台词生成虚拟角色的口型动作。

-

计算机视觉(Computer Vision):计算机视觉是人工智能的一个领域,让计算机能像人类一样理解和处理图像和视频信息。通过计算机视觉技术,模型可以分析和理解图像内容生成与输入图像相匹配的动作和表情。在EchoMimicV3中,计算机视觉技术用于处理图像输入,使生成的动画更加真实自然。

相关文章

暂无评论...